CUESTIONARIO SOBRE METODOLOGIA Y EVALUACIÓN EN FORMACIÓN INICIAL EN EDUCACIÓN FÍSICA

Castejón Oliva, F.J.1; Santos Pastor, M.L.2 y Palacios Picos, A.3

1Universidad Autónoma de Madrid. Departamento de Educación Física, Deporte y Motricidad Humana. Profesor Titular (javier.castejon@uam.es)

2Universidad Autónoma de Madrid. Departamento de Educación Física, Deporte y Motricidad Humana. Profesora Titular (marisa.santos@uam.es)

3Universidad de Valladolid. E.U. Magisterio de Segovia. Catedrático de Escuela Universitaria (palacios@psi.uva.es)

Financiación: Este trabajo forma parte del Proyecto de investigación Ref. EDU 2010-19637 del Plan Nacional de Proyectos I+D+i (2008-2011).

Código UNESCO / UNESCO code: 5801.07 Métodos Pedagógicos / Teaching methods.

Clasificación del Consejo de Europa / Council of Europe classification: 5. Didáctica y metodología / Didactic and methodology.

Recibido 27 de marzo de 2012 Received March 27, 2012

Aceptado 24 de junio de 2013 Accepted June 24, 2013

Castejón Oliva, F.J.; Santos Pastor, M.L. y Palacios Picos, A. (2015) Cuestionario sobre metodología y evaluación en formación inicial en educación física / Questionnaire on Methodology and Assessment in Physical Education Initial Training. Revista Internacional de Medicina y Ciencias de la Actividad Física y el Deporte, vol. 15 (58) pp. 245-267.

DOI: http://dx.doi.org/10.15366/rimcafd2015.58.004

RESUMEN

Este artículo describe el proceso de validación de una escala para conocer las percepciones sobre metodologías participativas y de evaluación formativa de estudiantes universitarios de titulaciones de Educación Física. Se ha realizado un proceso de validación de contenido, comprensión y fiabilidad del cuestionario en tres fases: En la primera, de validación de expertos con seis jueces expertos en evaluación universitaria; en la segunda, de validación de la comprensión, con una muestra de 50 estudiantes; en la tercera, de fiabilidad y validación general, con 892 estudiantes universitarios de 10 universidades españolas. Los resultados han mostrado la fiabilidad del instrumento y la confirmación con el análisis factorial. La escala resulta ser un instrumento válido para ayudar al profesorado a analizar las percepciones de los estudiantes en relación con las metodologías participativas y la evaluación formativa. Se espera que sea una herramienta eficaz para orientar el cambio y la mejora en la docencia universitaria.

PALABRAS CLAVE: Cuestionario, Validación, Evaluación formativa, Metodología participativa, Formación inicial, Educación física, Educación superior.

ABSTRACT

This article describes the validation process of a scale aimed at knowing the perceptions regarding participative methodologies and the formative evaluation of Physical Education university students. We have undertaken a process of validation of the contents, comprehensibility and reliability of the questionnaire in three stages: In the first one, expert validation with six expert judges in university evaluation; in the second, comprehensibility validation with a sample of 50 students; in the third, reliability and general validation, with 892 university students from 10 Spanish universities. Results show the reliability of the instrument and the confirmation with the factorial analysis. The scale has turned out to be a useful instrument to help teachers analyse students’ perceptions regarding participative methodologies and formative evaluation. We hope it becomes a useful tool to redirect modifications and improvements in university teaching.

KEYWORDS: Questionnaire, Validation, Formative assessment, Participative methodology, Initial training, Physical education, Higher education.

INTRODUCCIÓN

En los últimos años es notorio el interés por generar cambios en la docencia universitaria tanto en sus objetivos y finalidades, como en los planteamientos metodológicos y de la evaluación de los procesos de enseñanza-aprendizaje, tal como se anuncia en los objetivos del Consejo Europeo de Lisboa 2000 (Consejo Europeo, 2000; EEES, 2009). Se reclama una mejora en la implementación metodológica y en la aplicación de sistemas de evaluación diferenciados (Vázquez, 2008) con un fin de excelencia universitaria (Villa, 2008), una excelencia que debe cuestionarse cuando “alrededor del 80% de la evaluación que se emplea por todo el mundo se realiza en forma de exámenes y trabajos” (Brown y Glasner, 2007, p. 8).

Con el desarrollo de los grados universitarios tras la aprobación de los nuevos planes de estudio, hay una marcada propuesta de cambio en cuanto a la enseñanza universitaria. Entre los aspectos relevantes y significativos de este cambio se encuentra la metodología (Biggs, 2006; Tejedor, 2003) que, guiado por la idea de la búsqueda de la excelencia universitaria, supone: (a) proponer una metodología participativa, en el sentido de que se vincula con el aprendizaje activo (Millis, 2010; Meyer y Jones, 1993); (b) promover una comunicación entre profesorado y alumnado que incluye procesos reflexivos para conocer, comprender, analizar, aplicar, sintetizar y evaluar (Black y Wiliam, 2009; Huber, 2008); (c) establecer vínculos entre teoría y práctica, e integrar conocimientos para dar sentido a lo aprendido (Cano-González, 2009; Huber, 2008); (d) buscar diferentes formas de organización de los estudiantes y sus tareas (Marín-García, Miralles-Insa, García-Sabater, y Vidal-Carreras, 2008); y (e) usar instrumentos y soportes tecnológicos de la información (Cano-González, 2009).

En este nuevo marco, la evaluación debe vincularse con el concepto de evaluación formativa así podremos comprobar los resultados del proceso de aprender y no sólo los resultados que tratan la evaluación como sinónimo de calificación; además, se convertirá en un elemento de mejora y ayuda para el alumnado y para el profesorado (MacMillan, 2007; Pérez, Julián, y López-Pastor, 2009).

Los estudios resaltan que la valoración y la percepción de los estudiantes sobre el proceso de enseñanza-aprendizaje, no deja de ser una forma de que el propio profesorado mejore en su docencia (Marsh, 1987, 2007; Marsh y Roche, 1997), y parece necesario que se deba profundizar en ello como clave de la calidad en la enseñanza (Villa, 2008). La forma en la que los estudiantes entienden su propio aprendizaje, está condicionada por sus propias creencias sobre cómo aprenden las personas (Tippin, Lafreniere, y Page, 2012), pero también es fruto de cómo ellos mismos adquieren el conocimiento con la experiencia de su propia formación (Irons, 2008).

No obstante, son escasos los trabajos dedicados a la percepción del alumnado sobre los procesos de evaluación. Podemos resaltar las aportaciones de Marsh (1982) con el Estudents’ Evaluations of Educational Quality (SEEQ), cuyo trabajo considera ocho aspectos relacionados con las metodologías docentes y la evaluación formativa: (a) relación aprendizaje y su valor; (b) entusiasmo del instructor; (c) interacción del grupo; (d) informes individuales; (e) relación entre organización, claridad y amplitud de evidencias; (f) relación entre exámenes y notas; (g) lecturas y documentos de trabajo; y (h) relación entre carga de trabajo y dificultad.

Los estudios previos sobre la metodología y la enseñanza universitaria se centraron en la denominada enseñanza eficaz, cuyas claves eran: el interés y motivación del profesorado, el respeto por el ritmo de aprendizaje de los estudiantes, el disponer de objetivos claros, controlar los progresos del alumnado y aprender de los propios estudiantes (Race, 2007); sin olvidar otros factores centrado en la personalidad del profesorado (Feldman, 1986; Murray, Rushton, y Paunnem, 1990).

Otro estudio que se ha basado en los sistemas de evaluación de aprendizaje que utilizan los profesores es el Shortened Experiences of Teaching and Learning Questionnaire (SETLQ) (University of Edinburgh, 2001). Por su parte, Biggs (1987) se apoya en el estilo de aprendizaje de los estudiantes y el contexto de enseñanza; los trabajos de Entwistle y colaboradores (Entwistle, Hanley, y Hounsell, 1979; Entwistle y Peterson, 2004; Entwistle, Tait, y McCune, 2000) con el Approaches and Study Skills Inventory for Students (originalmente diseñado por Ramsden y Entwistle, 1981) muestran diferencias en cómo se entiende el estudio y el aprendizaje (Cano-García y Justicia-Justicia, 1994). En todos ellos se resalta como idea compartida una clara relación entre el contexto, la actividad propuesta, el contenido, los resultados deseados y la propia predisposición de los estudiantes (Bain, 2005; Cabrera y La Nasa, 2002).

De cualquier manera, el interés del profesorado por conocer su propia práctica supone atender, entre otros aspectos, a cómo plantear la enseñanza y la evaluación, sin tener que pasar por controles institucionales (Fuentes-Medina y Herrero, 1999; Stenhouse, 1987; Knight, 2005; Leathwood y Phillips, 2000; Ramos y Ortiz, 2010).

En el caso concreto de la formación inicial del profesorado se ha reclamado una mayor atención a las metodologías y sistemas de evaluación empleados en la docencia universitaria, precisamente porque se está formando a los futuros docentes (Gimeno, 2012).

Pero los trabajos sobre el tema son escasos. Incluso en aquellos estudios en los que se han utilizado cuestionarios sobre metodologías participativas y evaluación formativa, han sido generalmente más como medios que como fines, dedicando escasos recursos a sus características psicométricas. Palacios y López-Pastor (2013) desarrollan una Escala de Actitudes hacia la Evaluación Formativa y Participación del Alumnado (EAEF-PA) cuyo objetivo es medir las actitudes del alumnado hacia el empleo que hacen los docentes sobre la evaluación formativa. Y Gutiérrez-García, Pérez-Pueyo, Pérez-Gutiérrez, y Palacios-Picos (2011) elaboran un cuestionario dedicado a la evaluación formativa del alumnado donde comprueban la participación del alumnado en la evaluación, percepción de uso de estrategias y técnicas metodológicas, desarrollo de la clase y la valoración de competencias profesionales del docente.

No obstante y como venimos diciendo, pese a la importancia de poder disponer de información sobre el cambio posible hacia sistemas metodológicos más ricos y hacia sistemas de evaluación más formativos, actualmente no se disponen de instrumentos válidos y fiables de consulta de percepción de esos cambios, al menos en la opinión de uno de los elementos claves en estos procesos como son los alumnos.

OBJETIVO

Nuestro objetivo se ha centrado en diseñar y validar una escala de percepción sobre metodologías participativas y evaluación formativa (EMPEF) que nos permita valorar cómo metodología y evaluación son percibidas por los estudiantes durante su formación inicial, y el grado de satisfacción que se tiene con su puesta en práctica para conseguir los aprendizajes.

MÉTODO

Diseño

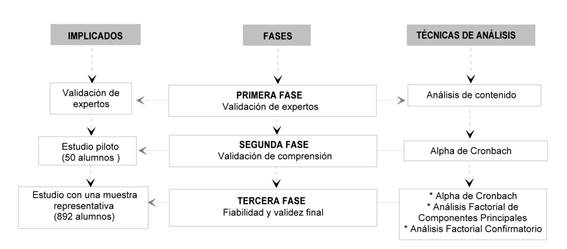

Se ha realizado un proceso de validación de contenido, comprensión y fiabilidad del cuestionario en tres fases. Una primera en la que se realiza con expertos en la materia, una segunda en la que se realiza un estudio piloto con el fin de concretar el cuestionario, y una tercera fase en la que se aplica el cuestionario a un grupo mayoritario de estudiantes de distintas universidades (Figura I).

Figura I.- Fases del proceso, personas implicadas y técnicas estadísticas utilizadas para la elaboración del EMPEF.

Participantes

En la primera fase han participado seis jueces expertos en evaluación universitaria. Llevan impartiendo docencia durante más de 10 años en universidades públicas, en la titulación de maestro especialista en EF y en la titulación de Licenciado en Ciencias de la Actividad Física y Deporte. Todos tienen el grado de doctor y han publicado artículos y libros sobre evaluación formativa y metodologías participativas en docencia universitaria. Esta selección ha sido intencional.

En la segunda fase, cuyo objetivo es obtener la validez de comprensión y un primer avance de la fiabilidad del instrumento, se ha seleccionado de forma intencionada a 50 estudiantes universitarios matriculados en distintos cursos de las dos carreras habituales en EF: maestro especialista en EF y licenciados en Ciencias de la Actividad Física y Deporte. La selección de esta muestra fue intencional.

La implementación de la tercera fase se realizó con una población de 892 estudiantes universitarios de 10 universidades españolas, que ofertaban los estudios de Maestro y Licenciatura de Ciencias de la Actividad Física y Deporte. La población cubría todos los cursos de cada titulación.

Procedimiento

Se proporcionó el cuestionario al grupo de expertos para comprobar el grado de coincidencia/divergencia de los términos utilizados y la valoración de las preguntas de los diferentes apartados, lo que configuró una primera versión del cuestionario. Esta primera versión fue administrada a un grupo de 50 estudiantes, representativos de la población final de estudio, lo que permitió comprobar la comprensión de los términos, la validez de campo, así como su fiabilidad y su consistencia interna. En una tercera fase, la versión final del cuestionario se aplicó a la muestra total de estudiantes, con los correspondientes permisos y manteniendo su anonimato en todo momento.

ANÁLISIS DE DATOS

Con la matriz de datos final, se extrajeron los factores del cuestionario de metodología participativa y evaluación formativa en la docencia universitaria mediante un Análisis Factorial Exploratorio (AFE) usando el programa estadístico SPSS 18.0. El método de extracción de factores utilizado fue el de componentes principales con rotación ortogonal (Varimax). Así mismo, se revisó la fiabilidad de la escala mediante el estadístico Alpha de Cronbach. Para constatar de forma más precisa la validez se realizó un Análisis Factorial Confirmatorio (AFC) mediante el programa informático Lisrel 8.6.

RESULTADOS

Primera fase: Validez de contenido

Para constatar la validez de contenido de la escala, las preguntas fueron definidas siguiendo los criterios de relevancia y representatividad con relación a la población a la que se dirigía y su dominio específico (Latiesa, 2000; Losada y López-Feal, 2003) y tomando en consideración trabajos anteriores relacionados con el tema (Fernández-Pérez, 1989; Gutiérrez-García et al., 2011; Palacios y López-Pastor, 2013; Prieto, 2007; Tejedor, 1998; Trillo, 2005; Trillo y Porto, 1999). Tras los correspondientes ajustes, se pasó a los expertos la escala inicial, previo consentimiento en la participación y su autorización. En una pequeña presentación se les indicaba el objetivo que se pretende con el cuestionario. Los expertos valoraron su grado de acuerdo con cada una de las preguntas de la escala según un baremo comprendido entre 1 y 4 (conformidad valores 3 y 4, y disconformidad valores 1 y 2). En el caso de disconformidad, se solicitaba una respuesta alternativa. Si no había alternativa alguna, se eliminaba la pregunta de la escala. De esta forma se obtenía el grado de precisión y corrección para la redacción de cada uno de los ítems.

El mayor desacuerdo se produjo a la hora de diferenciar entre metodología y evaluación (siguiendo la propuesta del concepto de “enseñanza alineada” de Biggs, 2006). Por ejemplo, uno de los evaluadores expertos (se mantiene su anonimato con claves) dice que:

¿Saben lo estudiantes lo que es esto que se les pregunta? ¿Conocen el significado de tanto concepto? Sin embargo, en este apartado de evaluación echo en falta otros importantes: ‘te devuelven –los profesores- los trabajos corregidos en un plazo breve de tiempo’; ‘se permite re-elaborar un trabajo o documento y volver a entregarlo’, etc. (EvExp1).

También hubo dudas en cuanto a la redacción de algunas preguntas relacionadas con el alcance de la evaluación (en una sola materia o en varias):

Se supone que el cuestionario es para evaluar la asignatura, no el plan o el centro. Aunque sí se considera interesante plantear esto, para ver el nivel de coordinación interna (puede ser interesante), entonces cambiaría ligeramente el texto: “Existen similitudes con los sistemas de evaluación de otras asignaturas de este mismo centro” (EvExp3).

Por otro lado, nuestra intención era utilizar una escala tipo Likert de 5 alternativas (de 1 a 5), pero todos los expertos sugirieron utilizar valores de 0 a 4, “puesto que la percepción y la medida son más correctas, así el equivalente a nada-ninguna mejor con el 0 que con el 1” (EvExp4).

Segunda fase: Validez de comprensión

Con las modificaciones realizadas en el apartado anterior, se pasó la prueba a dos grupos de 50 estudiantes, la mitad de la titulación de Maestro especialista en Educación Física y la otra de la licenciatura de Ciencias de la Actividad Física y el Deporte. En todos los casos se les solicitó y pidió permiso para participar en este trabajo. El objetivo en esta fase era comprobar si el tipo de preguntas era adecuado y el grado de comprensión de los enunciados. También se pretendía comprobar la duración total de la escala y si se encontraba dentro de límites aceptables para este tipo de pruebas.

La tarea de los alumnos consistía en puntuar el grado de comprensión que tenían respecto a los ítems ofrecidos. Para llegar a un grado de comprensión cualitativo del cuestionario, se les pedía que anotaran las dudas, las preguntas y las sugerencias. Se solicitó, por último, que indicaran qué ítems no entendían. Aquellas respuestas que eran anotadas con No sabe/No contesta (Ns/Nc) por más de un 5% de la muestra eran eliminadas directamente. Por otro lado, aquellas preguntas que ofrecían valores con la misma respuesta por encima del 90%, también eran eliminados. De esta forma se conseguía utilizar preguntas que discriminaran para valoraciones bajas o elevadas.

Así mismo, se realizó un análisis de la fiabilidad, para comprobar la consistencia de la medida cuando es repetido en diferentes ocasiones. Para el cálculo de la fiabilidad se ha utilizado el Coeficiente Alpha de Cronbach. Los resultados obtenidos en esta segunda fase son bastante elevados. Para toda la escala se alcanza un índice de fiabilidad de 0,92.

Para el cálculo de la fiabilidad en esta etapa no se incluyeron las preguntas 1 (con tres subpreguntas, una sobre negociación y otras dos sobre competencias), 14, 15 y 16 pues se tratan de preguntas independientes del constructo que se pretende medir (percepción de metodologías participativas y evaluación formativa) pero que aportan una valiosa información. Sus enunciados y resultados obtenidos en esta segunda fase los resumimos en la tabla I.

|

Preguntas |

Porcentajes |

||||

|

Nada |

Poco |

Bastante |

Mucho |

Ns/Nc |

|

|

Ítem 1a. ¿Se ha negociado el programa de la asignatura al comienzo del curso? |

10,4 |

25,0 |

27,1 |

16,7 |

20,8 |

|

Ítem 1b. ¿La metodología utilizada en la asignatura te ha ayudado a adquirir competencias profesionales? |

6,6 |

20,6 |

40,0 |

32,2 |

0,6 |

|

Ítem 1c. ¿La evaluación que se ha planteado favorece la adquisición de las competencias profesionales? |

7,2 |

21,5 |

45,3 |

24,4 |

1,6 |

|

Ítem 14. Señala la satisfacción global en relación con la asignatura |

6,4 |

25,5 |

36,2 |

19,1 |

12,8 |

|

Ítem 15. Señala la satisfacción global en relación con la evaluación de la asignatura |

2,1 |

10,4 |

31,3 |

29,2 |

27,0 |

|

Ítem 16. Señala cuál es el grado de dificultad de la asignatura |

8,6 |

32,2 |

39,8 |

3,8 |

15,6 |

Tabla I. Distribución de las respuestas sobre las preguntas no relacionadas directamente con el constructo que representa el cuestionario.

El ítem 1 refleja la negociación del programa, y se considera importante su presencia por la necesidad de comprobar si hay una negociación entre profesorado y alumnado. Los ítems 14, 15 y 16 reflejan valoraciones globales de la asignatura que se podrían tener en cuenta por si se pueden calcular correlaciones entre evaluación y metodología con ese grado de dificultad expresado. Al final del cuestionario se deja una pregunta abierta para que el alumnado pueda hacer algún comentario u observación.

Tercera fase: Fiabilidad y validez final

Una vez cerrado el cuestionario tal y como se desprende del estudio piloto de la segunda fase, fue cumplimentado por un conjunto amplio de estudiantes con el fin de comprobar su validez y fiabilidad. Como hemos comentado anteriormente, en esta tercera fase han participado 892 estudiantes de 10 universidades en las titulaciones de Magisterio y de la Licenciatura en Ciencias de la Actividad Física y Deporte. En todos los casos, se solicita y concede el permiso para poder participar en el estudio (profesorado, universidad y estudiantes).

El grupo se distribuye con un mayor porcentaje de hombres (55,1%) que de mujeres (44,9) y con una edad media de 21 años y 6 meses. La mayoría de los estudiantes que contestaron a los cuestionarios tenía un alto índice de asistencia y por ello, podemos decir que la información que proporcionan sugiere un conocimiento de lo que se hace a diario en las clases, tanto en metodología como en evaluación.

Escala de Metodologías Participativas. Con el total de la muestra se pasó a calcular de nuevo los índices de fiabilidad de la Escala de Metodologías Participativas basándonos en el Alfa de Cronbach. Como podemos comprobar en la Tabla II, el valor de 0,84 obtenido permite asegurar unas medidas de alta fiabilidad. Se decidió mantener todos los ítems originales de la escala pues la eliminación de cualquiera de ellos no producía un aumento significativo en el valor de la fiabilidad final.

|

Alfa de Cronbach |

Alfa de Cronbach basada en los elementos tipificados |

Nº de elementos |

|

,838 |

,845 |

24 |

Tabla II. Índice de fiabilidad de la Escala de Metodologías Participativas

Asegurada la fiabilidad de la escala, se pasó al análisis de sus factores implícitos mediante un Análisis Factorial de Componentes Principales (AFCP). Los resultados de este análisis los resumimos en la Tabla III. Se obtienen valores adecuados tanto en el índice KMO de 0,807 como en el test de esfericidad de Barlett (p>,00).

|

Componente |

Factores |

||||||

|

1 |

2 |

3 |

4 |

5 |

6 |

7 |

||

|

03. Recensiones de artículos o libros |

,683 |

|

|

|

|

|

|

F1 Metodologías basadas en informes y diarios escritos |

|

04. Informes |

,673 |

|

|

|

|

|

|

|

|

02. Diario o fichas de sesiones |

,593 |

|

|

|

|

|

|

|

|

01. Cuadernos de campo |

,574 |

|

|

|

|

|

|

|

|

09. Consultar bibliografía |

,521 |

|

|

|

|

|

|

|

|

06. Cuaderno o similar para la toma de apuntes |

,511 |

|

|

|

|

|

|

|

|

02. Se ha permitido preguntar dudas en las clases |

|

,806 |

|

|

|

|

|

F2 Métodos que potencian las relaciones humanas |

|

01. Se ha favorecido un clima de clase positivo |

|

,763 |

|

|

|

|

|

|

|

03. Las tutorías se han utilizado para resolver dudas sobre el desarrollo de la asignatura |

|

,587 |

|

|

|

|

|

|

|

04. Se han utilizado medios audiovisuales para el desarrollo de las clases (transparencias, presentaciones, vídeos, etc.) |

|

|

,796 |

|

|

|

|

F3 Metodologías clásicas con soporte Audiovisual y de las TICs |

|

05. Plataformas virtuales |

|

|

,657 |

|

|

|

|

|

|

07. En las clases se han utilizado exposiciones orales para las explicaciones y se tomaban apuntes |

|

|

,564 |

|

|

|

|

|

|

06. Lección magistral |

|

|

,526 |

|

|

|

|

|

|

02. Seminario |

|

|

|

,834 |

|

|

|

F4 Técnicas expositivas |

|

03. Estudio de casos |

|

|

|

,722 |

|

|

|

|

|

11. Mesas redondas |

|

|

|

,595 |

|

|

|

|

|

05. La asignatura se han acompañado de prácticas que ayudaban a entender mejor la posterior labor profesional |

|

|

|

|

,740 |

|

|

F5 Uso de prácticas profesionales |

|

10. Observación de prácticas docentes |

|

|

|

|

,685 |

|

|

|

|

06. Se han utilizado estrategias metodológicas variadas |

|

|

|

|

,495 |

|

|

|

|

07. Tertulias dialógicas |

|

|

|

|

|

,792 |

|

F6 Metodologías discursivas |

|

08. Debates |

|

|

|

|

|

,754 |

|

|

|

01. Proyectos tutelados |

|

|

|

|

|

|

,666 |

F7 Técnicas metodológicas grupales |

|

05. Aprendizaje colaborativo |

|

|

|

|

|

|

,591 |

|

|

04. Aprendizaje basado en problemas / resolución de problemas |

|

|

|

|

|

|

,410 |

|

|

Autovalores |

12,15 |

3,72 |

2,03 |

1,58 |

1,23 |

1,15 |

1,01 |

|

|

% Varianza explicada |

31,98 |

9,79 |

5,36 |

4,17 |

3,24 |

3,02 |

2,64 |

|

|

% Varianza explicada acumulada |

31,98 |

41,77 |

47,14 |

51,32 |

54,56 |

57,59 |

60,23 |

|

|

KMO: ,807 |

||||||||

|

Prueba Esfericidad de Barlett: Chi-cuadrado aproximado: 3808,87. gl. 276; sig: ,000 |

||||||||

Tabla III. Análisis Factorial de la Escala de Metodologías Participativas

El primero de los factores del cuestionario (F1), es el que explica la mayor cantidad de varianza (32%); tiene cargas significativas en cinco preguntas relacionadas con la elaboración de recensiones e informes, con las consultas bibliográficas, así como con la realización de diarios y cuadernos de campo; por todo ello, hemos denominado a este factor Metodologías basadas en informes y diarios escritos.

El segundo de los factores, que explicaría el 10% del total de la varianza de la escala, tiene un fuerte componente interpersonal con altas cargas factoriales en las preguntas siguientes: “se ha permitido preguntar dudas en la clase”, “se ha favorecido un clima de clase positivo” y “las tutorías se han realizado para resolver dudas sobre el desarrollo de la asignatura”. Se ha denominado a este factor Metodologías que potencian las relaciones interpersonales.

El tercer factor (F3) tiene cargas en aspectos tales como la utilización de medios audiovisuales para el desarrollo de las clases y del desarrollo de lecciones magistrales. Por ello, hemos denominado a este factor Metodologías clásicas con soporte audiovisual y de las TICs; explica un 4% de la varianza total.

El cuarto factor (F4) lo hemos denominado Técnicas metodológicas expositivas innovadoras y estudio de casos por tener valores significativos en preguntas relacionadas con la utilización de estas estrategias de estudio, con los seminarios y con las mesas redondas.

Los factores 5 y 6 tienen valores en dos únicos ítems cada uno y con una varianza explicada del 3% cada uno. El primero de los señalados, tiene un claro componente práctico como estrategias metodológicas con valores significativos en las preguntas: “la asignatura se han acompañado de prácticas que ayudaban a entender mejor la posterior labor profesional” y en “la observación de prácticas docentes”. Por su parte, el segundo de los factores indicados (F6) tiene cargas elevadas en el uso de “tertulias dialógicas” y “debates”, razón por la cual le hemos denominado al factor Metodologías discursivas.

El último de los factores, con un autovalor superior a 1, explica el 3% de la varianza total y, correlaciona de manera importante con tres ítems cuales son: “la realización de proyectos tutelados”, “el aprendizaje colaborativo” y “el aprendizaje basado en resolución de problemas”. Por ello, lo hemos denominado Técnicas metodológicas grupales.

Para asegurar la validez de contenido, se ha realizado un Análisis Factorial Confirmatorio (AFC) de los siete factores antes descritos. Los índices obtenidos a partir de la matriz de covarianzas, presentaron ajustes satisfactorios: tanto en el índice RMSEA = 0.078, como en el GFI = 0.88, como en los restantes valores de ajuste del modelo (Tabla IV).

|

Modelo |

S-B(Chi-cuadrado) (gl) (p) |

GFI |

RMSEA |

NFI |

NNFI |

CFI |

AGFI |

AIC |

|

Factores Escala |

1358,91 (231)(P = .00) |

,88 |

,078 |

,86 |

,86 |

,88 |

,84 |

10194,78 |

Tabla IV. Evaluación del modelo de siete factores de las Escalas de Metodologías Participativas mediante AFC

Escala de sistemas de evaluación. Como hiciéramos con la Escala de Metodologías Participativas, se ha realizado el análisis de la fiabilidad de la Escala de Sistemas Evaluación mediante el Alfa de Cronbach, cuyos resultados resumimos en la Tabla V.

|

Alfa de Cronbach |

Alfa de Cronbach basada en los elementos tipificados |

Nº de elementos |

|

,839 |

,868 |

38 |

Tabla V. Índice de fiabilidad de la Escala de Sistemas de Evaluación

El Alfa obtenido de 0.83 permite concluir que estamos ante una escala con un índice de fiabilidad muy alto. Como sucediera con la escala anterior, se decidió no eliminar ninguno de los 38 ítems de la escala original pues de dicha eliminación no se obtenían valores significativamente mayores en la escala total.

El Análisis Factorial de Componentes Principales (AFCP) obtuvo seis factores que explicarían el 60% de la varianza total de la escala. Tanto el índice de KMO de .087 como la prueba de esfericidad de Barlett (p>.00), indican la pertinencia de este análisis y la significatividad estadística de su resultados (Tabla VI).

|

|

Componente |

Factores |

|||||

|

1 |

2 |

3 |

4 |

5 |

6 |

||

|

11. Se aprende mucho más(*) |

,799 |

|

|

|

|

|

F1 Evaluación orientada a los procesos de aprendizaje |

|

09. Permite aprendizajes funcionales |

,779 |

|

|

|

|

|

|

|

10. Genera aprendizajes significativos |

,776 |

|

|

|

|

|

|

|

12. Mejora la calidad de los trabajos exigidos |

,774 |

|

|

|

|

|

|

|

08. Mejora la tutela académica (seguimiento y ayuda al alumno) |

,765 |

|

|

|

|

|

|

|

06. El alumno está más motivado, el proceso de aprendizaje es más motivador |

,746 |

|

|

|

|

|

|

|

07. La calificación es más justa. |

,743 |

|

|

|

|

|

|

|

14. Evalúa todos los aspectos posibles |

,733 |

|

|

|

|

|

|

|

13. Hay interrelación entre teoría y práctica |

,673 |

|

|

|

|

|

|

|

15. Hay retroalimentación y posibilidad de corregir errores en documentos y actividades |

,650 |

|

|

|

|

|

|

|

04. El estudiante realiza un aprendizaje activo |

,649 |

|

|

|

|

|

|

|

16. Se da un seguimiento más individualizado |

,629 |

|

|

|

|

|

|

|

01. Ofrece alternativas a todos los estudiantes |

,628 |

|

|

|

|

|

|

|

17. Requiere más responsabilidad |

,611 |

|

|

|

|

|

|

|

03. Está centrado en el proceso, importancia del trabajo diario |

,575 |

|

|

|

|

|

|

|

02. Hay un contrato previo, negociado y consensuado del sistema de evaluación |

,559 |

|

|

|

|

|

|

|

05. Se plantea el trabajo en equipo de forma colaborativa |

,504 |

|

|

|

|

|

|

|

11. Es injusto frente a otros procesos de evaluación |

|

,713 |

|

|

|

|

F2 Anti-evaluación |

|

10. Genera inseguridad e incertidumbre, dudas sobre que hay que realizar |

|

,698 |

|

|

|

|

|

|

12. Las correcciones han sido poco claras |

|

,670 |

|

|

|

|

|

|

09. El proceso es más complejo y, a veces, poco claro |

|

,664 |

|

|

|

|

|

|

13. La valoración del trabajo es subjetiva |

|

,592 |

|

|

|

|

|

|

02. Se utilizaban procesos de evaluación formativa (el profesor corregía las actividades y/o documentos, informando sobre cómo mejorar y corregir los errores) |

|

|

,748 |

|

|

|

F3 Evaluación formativa |

|

03. Las observaciones realizadas sobre los trabajos y/o actividades demandadas, podía derivar en su repetición para mejorarlos |

|

|

,745 |

|

|

|

|

|

01. Se realizaban procesos de evaluación continua (evaluaciones de actividades y/o documentos durante el desarrollo de la asignatura) |

|

|

,665 |

|

|

|

|

|

07. Se puede acumular mucho trabajo al final |

|

|

|

,751 |

|

|

F4 Evaluación no planificada |

|

08. Existe una desproporción trabajo/créditos |

|

|

|

,640 |

|

|

|

|

05. Exige un mayor esfuerzo |

|

|

|

,574 |

|

|

|

|

06. Existe dificultad para trabajar en grupo |

|

|

|

,548 |

|

|

|

|

01. Exige una asistencia obligatoria y activa |

|

|

|

|

,817 |

|

F5 Evaluación basada en la asistencia |

|

03. Exige continuidad |

|

|

|

|

,715 |

|

|

|

04. Se utilizaba un portafolios o carpeta individual para entregar materiales |

|

|

|

|

|

,826 |

F6 Evaluación basada en Portafolios |

|

05. Se utilizaba un portafolios grupal o carpeta colaborativa para entregar materiales |

|

|

|

|

|

,748 |

|

|

07. Han existido similitudes con los sistemas de evaluación de otras asignaturas de este mismo centro |

|

|

|

|

|

,560 |

|

|

Autovalores |

12,15 |

3,72 |

2,04 |

1,58 |

1,23 |

1,15 |

|

|

% Varianza explicada |

31,98 |

9,79 |

5,36 |

4,17 |

3,24 |

3,02 |

|

|

% Varianza explicada acumulada |

31,98 |

41,77 |

47,14 |

51,32 |

54,56 |

57,59 |

|

|

KMO: ,807 |

|||||||

|

Prueba Esfericidad de Barlett: Chi-cuadrado aproximado: 3808,87. gl. 276; sig: ,000 |

|||||||

Tabla VI. Análisis Factorial de la Escala de Sistemas de Evaluación (No se listan los 4 ítems con valores factoriales menores de 0,35)

El primero de los factores, el más numeroso con pesos factoriales en un total de 19 preguntas, explica el 32% de la varianza total. Pese a la heterogeneidad que presentan estas preguntas (sistemas de evaluación que favorecen el aprendizaje y el aprendizaje significativo, mejora de las relaciones interpersonales y didácticas, utilización de procesos de evaluación formativa, etc.), tienen en común el que bien podrían ser indicadores de una Evaluación orientada a los procesos de aprendizaje.

En el segundo de los factores se obtienen las correlaciones más elevadas en las preguntas: el sistema de evaluación empleado es injusto frente a otros procesos de evaluación, genera inseguridad e incertidumbre, con correcciones poco claras y con procesos igualmente confusos y con una alta carga de subjetividad en las valoraciones. Por todo ello, le hemos denominado Anti-evaluación.

El tercer factor explica el 5% de la varianza total del cuestionario con correlaciones elevadas en las preguntas: se utilizaban procesos de evaluación formativa, las observaciones realizadas sobre los trabajos y/o actividades demandadas podrían derivar en su repetición para mejorarlas; se ha identificado el factor como Evaluación Formativa.

El cuarto de los factores encontrados tendría que ver con cuatro preguntas del cuestionario relacionadas con una inadecuada organización temporal de los procesos de evaluación, con una percepción elevada de asignación de recursos para evaluar así como una cierta incapacidad para trabajar con el equipo educativo; por estas razones hemos denominado a este factor Evaluación no planificada. Explica algo más del 4% de la varianza total.

El quinto factor posee valores en dos únicas preguntas cuales son: exige una asistencia obligatoria y activa, y exige continuidad; por lo que identificamos el factor como Evaluación basada en la asistencia.

El sexto y último factor tiene que ver, sobre todo, con el uso de portafolios o carpetas tanto individuales como colaborativas, por lo que denominamos a este factor Evaluación basada en portafolios; explica el 3% de la varianza total del cuestionario.

Como hiciéramos con la escala anterior, se realizó un Análisis Factorial Confirmatorio (AFC) con el total de preguntas de la Escala de Sistemas de Evaluación y los resultados de los seis factores antes analizados. Ahora como antes, todos los indicadores de dicho análisis indicaron un buen ajuste del modelo y, por tanto, de la existencia de esos factores a los que nos venimos refiriendo (Tabla VII).

Modelo |

S-B(Chi-cuadrado) (gl) (p) |

GFI |

RMSEA |

NFI |

NNFI |

CFI |

AGFI |

AIC |

|

Factores Escala (seis factores) |

2687,03 (545)(P = 0,00) |

,84 |

,070 |

,95 |

,96 |

,084 |

,81 |

46310,71 |

Tabla VII. Evaluación del modelo de seis factores de la Escala de Sistemas de Evaluación mediante AFC

DISCUSIÓN Y CONCLUSIONES

El objetivo de la escala EMPEF para valorar cómo son percibidas por profesorado y alumnado la metodología participativa y la evaluación formativa en la formación inicial en Educación Física ha sido confirmado por el análisis factorial exploratorio.

Los resultados muestran una estructura de siete factores en el caso de la metodología y de seis en la evaluación. El hecho de no tener como referencia otros estudios que respondan a los mismos aspectos que la escala aquí presentada es una de las carencias que puede asumirse, pero es cierto que aquellos trabajos que aportan información sobre temas de metodología y evaluación en general no profundizan en la misma medida que el EMPEF. Por ejemplo, el SETLQ (University of Edinburgh, 2001) contiene preguntas referidas a objetivos y congruencias (5), elecciones sobre contenidos (2), enseñanza y aprendizaje (5), feedback (5), evaluación comprensiva (2), motivación y entusiasmo (4), interés por el curso (2), que no corresponden a los mismos factores de nuestro estudio. También se diferencia de las propuestas de Entwistle y colaboradores (Entwistle, Hanley, y Hounsell, 1979; Entwistle y Peterson, 2004; Entwistle, Tait, y McCune, 2000) con el Approaches and Study Skills Inventory for Students pues preferiblemente lo usan para el tipo de aprendizaje conseguido (profundo, estratégico y superficial), aunque contiene algunas preguntas sobre enseñanza y evaluación, pero no relacionadas con los conceptos de metodología participativa y evaluación formativa. Es el trabajo de Gutiérrez-García et al. (2011) el que sí contiene algunos ítems que pueden relacionarse con el EMPEF, además de que su población de estudio también es de formación inicial en educación física. Así, en metodología contiene 17 ítems, pero no queda claro que correspondan con el mismo concepto de metodología participativa que aquí se ha expuesto. Sí incluye evaluación formativa, y aquí hay que remarcar que los resultados, en las preguntas que tienen un mismo sentido al que tiene el EMPEF, muestran resultados semejantes.

En suma, el EMPEF puede ser aplicado por el profesorado para comprobar las percepciones de los estudiantes sobre metodologías participativas y evaluación formativa e identificar los beneficios y las dificultades de la puesta en práctica de planteamientos innovadores en relación con la metodología y la evaluación. Es lo suficientemente extenso como para abarcar estos aspectos de la enseñanza y ha mostrado la validez necesaria para aplicarse en la formación inicial en las titulaciones de Educación Física. Las líneas de investigación que pueden desarrollarse con la aplicación de este instrumento pueden ayudar al profesorado para comprobar cómo es su docencia y su evaluación, pudiendo centrarse en los indicadores que debe mejorar.

REFERENCIAS BIBLIOGRÁFICAS

Bain, K. (2005). Lo que hacen los mejores profesores universitarios. Valencia: Universidad de Valencia.

Black, P., y Wiliam, D. (2009). Developing the theory of formative assessment. Assessment, Evaluation and Accountability, 21(1), 5-31. http://dx.doi.org/10.1007/s11092-008-9068-5

Biggs, J. (1987). Student approaches to learning and studying. Research monograph. Melbourne: Australian Council for Educational Research. Recuperado de http://www.eric.ed.gov/ERICWebPortal/search/detailmini.jsp?_nfpb=true&_&ERICExtSearch_SearchValue_0=ED308201&ERICExtSearch_SearchType_0=no&accno=ED308201

Biggs, J. (2006). Calidad del aprendizaje universitario (2ª ed.). Madrid: Narcea.

Brown, S., y Glasner, A. (Eds.) (2007). Evaluar en la Universidad. Problemas y nuevos enfoques. Madrid: Narcea.

Cabrera, A.F., y La Nasa, S. (2002). Sobre los métodos de ense-anza en la Universidad y sus efectos. Diez lecciones aprendidas. En C. Adelman (Ed.), Nuevas miradas sobre la universidad (pp. 63-88). Buenos Aires: Universidad Nacional de Tres de Febrero.

Cano-García, F., y Justicia-Justicia, F. (1994). Learning strategies, styles and approaches: an analysis of their interrelationships. Higher Education, 27, 239-260. http://dx.doi.org/10.1007/BF01384091

Cano-González, R. (2009). Tutoría universitaria y aprendizaje por competencias. ¿Cómo lograrlo? REIFOP, 12(1), 181-204. Recuperado de http://www.aufop.com

Consejo Europeo (2000). Conclusiones de la presidencia. Recuperado de http://www.europarl.europa.eu/summits/lis1_es.htm

EEES. (2009). Declaración de Leuven/Louvain-la-Neuve, 28-29 April 2009. Recuperado de http://www.eees.es/pdf/Leuven_Louvain-la-Neuve_Communique_April_2009.pdf

Entwistle, N., Hanley, M. y Hounsell, D. (1979). Identifying distinctive approaches to studying. Higher Education, 8(4), 365-380. http://dx.doi.org/10.1007/BF01680525

Entwistle, N. J., y Peterson, E. R. (2004). Conceptions of learning and knowledge in higher education: Relationships with study behaviour and influences of learning environments. International Journal of Educational Research, 41, 407-428.

http://dx.doi.org/10.1016/j.ijer.2005.08.009

Entwistle, N., Tait, H., y McCune, V. (2000). Patterns of response to approaches to studying inventory across contrasting groups and contexts. European Journal of Psychology of Education, 15(1), 33-48. http://dx.doi.org/10.1007/BF03173165

Feldman, K. A. (1986). The perceived instructional effectiveness of college teachers as related to their personality and attitudinal characteristics: A review and synthesis. Research in Higher Education, 234, 129-213.

http://dx.doi.org/10.1007/bf00991885

Fernández Pérez, M. (1989). Así ense-a nuestra Universidad: Hacia la construcción crítica de una didáctica universitaria. Madrid: Editorial Complutense.

Fuentes-Medina, M. E., y Herrero, J. R. (1999). Evaluación docente: Hacia una fundamentación de la autoevaluación. Revista Electrónica Interuniversitaria de Formación del Profesorado, 2(1). Recuperado de http://www.uva.es/aufor/publica/revelfor/99-v2n1.htm

Gimeno, J. (2012). ¿Por qué habría de renovarse la ense-anza en la Universidad? En J.B. Martínez (Coord.), Innovación en la universidad. Prácticas, políticas y retóricas (pp. 27-51). Barcelona: Graó.

Gutiérrez-García, C., Pérez-Pueyo, A., Pérez-Gutiérrez, M., y Palacios-Picos, A. (2011). Percepciones de profesores y alumnos sobre la ense-anza, evaluación y desarrollo de competencias en estudios universitarios de formación de profesorado. Cultura y Educación, 23(4), 499-514.

http://dx.doi.org/10.1174/113564011798392451

Huber, G.L. (2008). Aprendizaje activo y metodologías educativas. Revista de Educación, número extraordinario, 59-81.

Irons, A. (2008). Enhancing Learning through Formative Assessment and Feedback. New York: Routledge.

Knight, P.T. (2005). El profesorado de educación superior. Madrid: Narcea.

Latiesa, M. (2000). Validez y fiabilidad de las observaciones sociológicas. En M. García Ferrando, J. Ibá-ez, y F. Alvira (Comps.), El análisis de la realidad social. Métodos y técnicas de investigación (pp. 409-443). Madrid: Alianza.

Leathwood, C., y Phillips, D. (2000). Developing curriculum evaluation research in higher education: Process, politics and practicalities. Higher Education, 40, 313-330. http://dx.doi.org/10.1023/A:1004183527173

Losada, J. L., y López-Feal, R. (2003). Métodos de investigación en ciencias humanas y sociales. Madrid: Thomson.

McMillan, J. H. (ed.) (2007). Formative Classroom Assessment. Theory into Practice. New York: Teachers College Press.

Marín-García, J. A., Miralles-Insa, C., García-Sabater, J. J., y Vidal-Carreras, P. I. (2008) Ense-ando Administración de Empresas con docencia basada en el trabajo en equipo de los estudiantes: Ventajas, inconvenientes y propuestas de actuación. Intangible Capital, 4(2), 143-165.

Marsh, H. W. (1982). SEEQ: A reliable, valid, and useful instrument for collecting students’ evaluations of university teaching. British Journal of Educational Psychology, 52, 77-95. http://dx.doi.org/10.1111/j.2044-8279.1982.tb02505.x

Marsh, H. W. (1987). Students’ evaluations of university teaching: Research findings, methodological issues, and directions for future research. International Journal of Educational Research, 11, 253-388 (whole issue).

http://dx.doi.org/10.1016/0883-0355(87)90001-2

Marsh, H. W. (2007). Students’ evaluations of university teaching: Dimensionality, reliability, validity, potential biases, and usefulness. En R. P. Raymond, y J. C. Smart (Eds.), The scholarship of teaching and learning in higher education: An evidence-based perspective (pp. 319-383). Dordrecht, The Netherlands: Springer http://dx.doi.org/10.1007/1-4020-5742-3_9

Marsh, H. W., y Roche, L. A. (1997). Making students’ evaluations of teaching effectiveness effective. The critical issues of validity, bias, and utility. American Psychologist, 52(11), 1187-1197. http://dx.doi.org/10.1037/0003-066X.52.11.1187

Meyer, C., y Jones, T. B. (1993). Promoting active learning: Strategies for the college classroom. San Francisco: Jossey-Bass.

Millis, B. (ed.) (2010). Cooperative Learning in Higher Education: Across the Disciplines, Across the Academy. Sterling: Stylus Publishing.

Murray, H. G., Rushton, J. P., y Paunnem, S. V. (1990). Teacher personality traits and student instructional ratings in six types of university courses. Journal of Educational Psychology, 82(2), 250-261. http://dx.doi.org/10.1037/0022-0663.82.2.250

Palacios, A. y López-Pastor, V. (2013). Haz lo que yo digo pero no lo que yo hago: sistemas de evaluación del alumnado en la formación inicial del profesorado. Revista de Educación, 361, 279-305.

Pérez, Á., Julián, J. A., y López-Pastor, V. M. (2009). Evaluación formativa y compartida en el Espacio Europeo de Educación Superior. En V.M. López-Pastor, (coord.), Evaluación formativa y compartida en Educación Superior (pp. 19-43). Madrid: Narcea.

Prieto, L. (2007). Autoeficacia del profesor universitario: eficacia percibida y práctica docente. Madrid: Narcea.

Race, P. (2007). The Lecturer’s Toolkit: A practical guide to assessment, learning and teaching. New York: Routledge.

Ramos, F., y Ortiz, M. (2010). Una experiencia de auto-evaluación de profesorado: teoría y práctica. Exedra, 4, 81-107.

Ramsden, P., y Entwistle N.J. (1981). Effects of academic departments on students’ approaches to studying. British Journal of Educational Psychology, 51(3), 368-383. http://dx.doi.org/10.1111/j.2044-8279.1981.tb02493.x

Stenhouse, L. (1987). La investigación como base de la ense-anza. Madrid: Morata.

Tejedor, F. (Dir.) (1998). Las estrategias utilizadas por los profesores universitarios para la evaluación del aprendizaje de los alumnos. Madrid: CIDE (informe).

Tejedor, F. (2003). Un modelo de evaluación del profesorado universitario. Revista de Investigación Educativa, 21(1), 157-182.

Tippin, G.K., Lafreniere, K.D., y Page, S. (2012). Student perception of academic grading: Personality, academic orientation, and effort. Active Learning in Higher Education, 13(1), 51-61. http://dx.doi.org/10.1177/1469787411429187

Trillo, F. (2005). La evaluación de los estudiantes universitarios. El caso de la Universidad de Santiago de Compostela. Santiago de Compostela: Universidad de Santiago de Compostela.

Trillo, F., y Porto, M. (1999). La percepción de los estudiantes sobre su evaluación en la universidad. Un estudio en la Facultad de Ciencias de la Educación. Innovación Educativa, 9, 55-75.

University of Edinburgh (2001). ProjectETL. Shortened Experiences of Teaching and Learning Questionnaire (SETLQ). Disponible en www.etl.tla.ed.ac.uk/docs/SETLQscoring.pdf

Vázquez, J. A. (2008). La organización de las ense-anzas de grado y postgrado. Revista de Educación, número extraordinario, 23-39.

Villa, A. (2008). La excelencia docente. Revista de Educación, número extraordinario, 177-212.

Referencias totales / Total references: 48 (100%)

Referencias propias de la revista / Journal’s own references: 0 (0%)